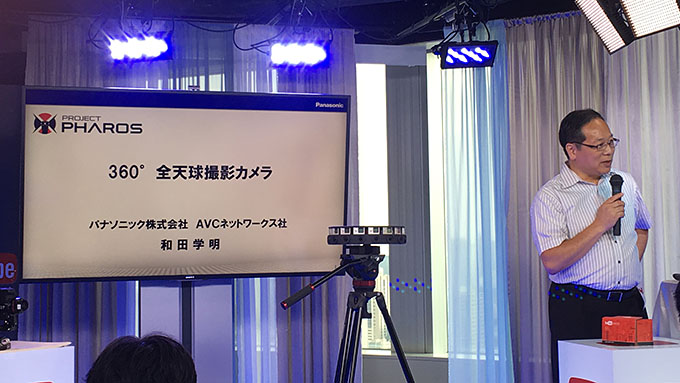

4K/30fpsで非圧縮! パナソニックのライブ配信向け360度カメラ試作「Project PHAROS」を見た

グーグルは2日に開催した「YouTube Space Tokyo 360/VR シンポジウム」では、YouTube Liveの生配信で使える360度カメラとして、先日提携が発表されたクロスデバイスの「mooovr」とパナソニックの「Projectg PHAROS」が紹介された。

Projectg PHAROSは、今年4月の放送業界向けイベント「NAB 2016」にて披露し、いくつかの展示会に出展してきたとのこと。日本では8月頭にテレビ東京の報道番組「ワールドビジネスサテライト」で紹介されたそうだが、が国内で一般公開するのは初めてということなのでまとめていこう。

「映像の匠」たちが手がけた本気の360度カメラ

Project PHAROSは、製品ではなくまだ試作機で、発売時期も価格も明らかにされていない。PHAROSという名前も、製品ではなくチームの名前に相当する。その一番の特徴は、4つのレンズを使って撮影した映像を外部ユニットに取り込み、リアルタイムでスティッチングしてくれるという点だ。

そもそもの話、360×180度の映像を撮影する際には、どんなに広角なものを使っても1つのレンズではカバーできないため、2つ以上のレンズで撮影した映像をくっつける作業が必要になる。これをスティッチングと呼ぶ。

先のYouTube Live 360の記事でも触れたが、このスティッチングをリアルタイムでできるソリューションがそもそも限られており、さらに高画質で360度配信しようとすると、複数台の一眼レフ+広角or魚眼レンズとViedoStichの「Vahana VR」を組み合わせて使うことが多い(ちなみにNextVRはREDを使っていたこともあった)。後編集を前提とした360度撮影用のシステムですら発展途上中なのに、生配信用となると、さらに厳しい条件になる。

そんな殺伐とした(?)状況に現れたのが、業務用の放送機器で定評のあるパナソニックが手がけたProject PHAROSというわけだ。

プレゼンで解説したのは、パナソニック AVCネットワークス社の和田学明氏。もともとスタジオカメラの開発・責任者を担当し、ほかにも渋谷の街を写すような屋外に置く「BOXカメラ」や、回転台とズームレンズを一体型にした「PTZカメラ」なども手がけてきた。3Dカメラの開発にも関わり、米国で「R&D 100 Awards」を受賞したこともあった。最近でいえば、一眼レフの「LUMIX DMC-GH4」で、映像制作の現場で役立つ動画機能を充実させたのも和田氏のチームの仕事だ。

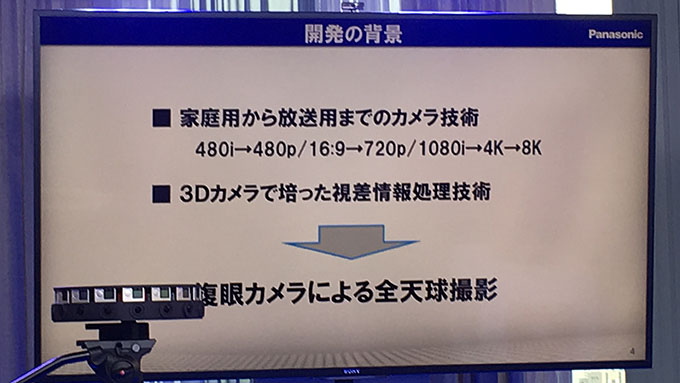

360度カメラの開発背景には、まずパナソニックが家庭用から放送用までカメラの技術を持っているという前提がある。さらに3Dカメラで視差情報の処理技術を持っているので、複眼カメラで360度を撮れるものをつくろうという流れになった。

2年ほど前から、試作機をつくっては技術検証を行うというサイクルを回してきて、今回披露したのが最新のものになる。

最新バージョンでは、カメラヘッドとベースユニットに大きく分かれており、4K/30fpsで正距円筒図法で映像の出力が可能。カメラヘッドは、4台のカメラを水平に90度ずつ向きを変えて配置している。縦方向は186度カバーしていて、天地の撮影も可能だ。カメラのすぐ近くは撮影できないエリアがあるが、少なくとも1m以上離れれば全部撮影が可能。下のベースユニットにはスティッチングプロセッサーを内蔵しており、リアルタイムで統合処理をしてくれる。

一番の特徴は、リアルタイムスティッチ。カメラに光が入ってきてから信号処理をして出力するまで0.3秒という遅延で出力できるので、特にライブの映像配信に適している。

2つ目は、自動視差補正。カメラヘッドで撮影された映像は4つの縦向きの映像になるが、通常、スティッチの境目に被写体があると、距離によって映像が歪んでしまう。PHAROSでは、2眼分の重なっている部分の映像から被写体の距離を解析して、なるべくずれが起こらないように補正してくれる。

4眼のカメラがバラバラに撮像していると、動いているものを撮ろうとしたときに、露光タイミングの違いからズレが起こってしまう。3つ目は、この問題を完全にタイミングを同期することで解決している。

4つ目は、軽度の輝度レベルやホワイトバランスを自動で合わせてくれる機能。4台のカメラをバラバラにオートアイリスやオートホワイトバランスで撮影していると、例えば、太陽がある面だけ輝度レベルがさがってしまうということが起こってしまう。PHAROSでは、4台のカメラをマッチングするように補正している。

5つ目は、PCを使ってコントロールできる機能。LANケーブルでつないで、映像をモニターしながらシャッタースピードを変えたり、ホワイトバランスを調節したり、スティッチングの手動補正などが可能。現状ではまだ完全に作り込めていないそうだが、設計思想としては入っている。

最後の6つ目は、電源がDC12〜16Vで使えるので、ACアダプターや業務用バッテリーでの運用が可能。

現状の試作機を使った例では、中国のクイズ番組でおいてテスト撮影したり、シンガポールの一大イベントである独立記念日のパレードも配信した。スタジアムの中に360度カメラをおいて、撮影した映像を中継機の「LiveU」で別の事務所に無線転送して、そこからYouTubeのサイトにつないだ。3時間連続で撮影できたとのことで、長時間のライブ配信の実績となったそうだ。

今後の目標は、ハードとソフトの商品化。あとはフレームレートを60pに引き上げたり、4Kにとどまらず8Kをにらんで開発を進めていきたいそうだ。

数秒前の自分を360度で視聴できる

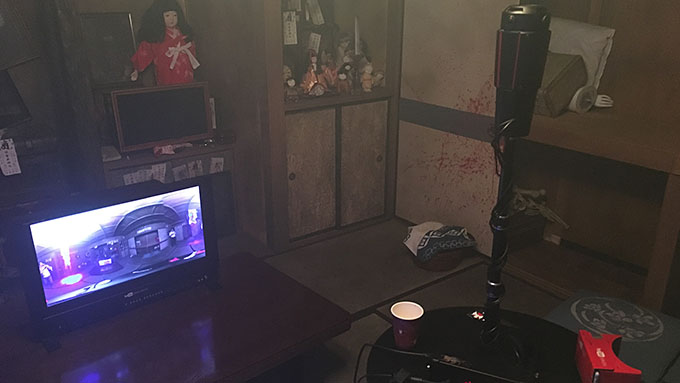

別室に用意された実機を見てみたが、まずコンパクトさと画質に驚いた。先のVahana VRで必要になるようなごついデスクトップは置いておらず、小型のベースユニットだけで、外部モニターにリアルタイムで出力していた。なお、部屋がおどろおどろしいのは、YouTube Space Tokyoにあるそうしたセットの部屋がたまたま割り当てられていただけなので、あまり気にしないでほしい。

カメラヘッドは、某コーヒーチェーンの「ベンティ」サイズのカップをもう少し大きくしたイメージ。上部には4つのマイクが仕込まれているが、今のところ3Dオーディオはうたっていない。一応、ファンが仕込まれていて、熱を持ちがちなユニットを冷やしてくれる。天面のパナソニックロゴがいいですね。

そんなカメラヘッドから4本のケーブルが伸びて映像が出力されて、下部のベースユニットに集められて……。

スティッチング後に背面のHDMI端子から出力される。ただし非圧縮で出てくるためこのままでインターネットに流すのは困難で、配信には別途圧縮するマシンが必要になる。

ライブ配信の映像をGoogle Cardboardで見られるデモも実施していた。ぐるりと見回すと、PHAROSの前に立った数秒前の自分がそこにいるのが不思議な感覚だった。

パナソニックの方によれば、海外などの展示会で披露していくとのこと。機会が合えば、ぜひとも現物をチェックしてほしい。

ちなみにPANORAでも9月12日に、「ポストモーテムVR #02 360度化するライブ配信の今」というイベントを実施するので、ぜひご参加下さい。申し込みページはこちら。

(TEXT by Minoru Hirota)

●関連リンク

・YouTube Space Tokyo

・パナソニック AVCネットワークス社