【ねこますさん特別寄稿】今日から使いたい、キャラクターに魂を宿す「AniCast」の魔法

ユニティ・テクノロジーズ・ジャパンが7〜9日に開催したUnity開発者向けイベントの「Unite Tokyo 2018」。今をときめくバーチャルYouTuberをからめた講演もちらほらあり、3日目にあたる9日には「AniCast!東雲めぐちゃんの魔法ができるまで」と題し、近藤“GOROman”義仁氏をはじめとするエクシヴィの4人が登壇して、キャラクターを生き生きと動かすノウハウを大公開していた。

Unite自体は、半年後以降に起こるトレンドをピックアップして技術者に伝授する場なのだが、今、バーチャルYouTuberを運営しいてる人物がこのイベントを体験したらどう響くのか。PANORAでは「バーチャルのじゃロリ狐娘YouTuberおじさん」こと「ねこます」さんをリアルワールドに召喚してあちこち回ってもらったところ、このAniCastの講演について「ぜひ書きたい!」という話をいただいた。

なにがねこますさんのテンションを上げたのか。ぜひ直筆原稿(といってもデータですが)をチェックしてほしい。

AniCastは、VR技術を使い、自宅で一人でもアニメの配信や制作ができるツール。

エクシヴィのほか、シーエスレポーターズの「Gugenka」ブランド、SHOWROOMがタッグを組んで……。

東雲めぐちゃんのライブを、毎週月〜金の7時30分、日曜日の19時にSHOWROOMにて配信している。

#uniteTokyo2018 XVIさん講演の質疑応答で東雲めぐちゃんが生出演中! pic.twitter.com/78dtvYjFvQ

— PANORA (@panoravr) May 9, 2018

会場では、東雲めぐちゃんが生登場し、来場者からの質問を受けていた。

目や口の表現を突き詰めて「魂」を注入

全体を通して、非常に実践的な知見が多く、すぐにでも挑戦したいと思えるような内容でした。アニメ的表現でありながら、キャラクターに生気を与えるAniCastの魔法と工夫を箇条書きで紹介してゆこうと思います。

●1.目の表現

目(瞳)が止まっているキャラクターはどうしても生気を感じづらくなってしまいます。逆に無機物やロボットなどの表現をするときには止めた方が有効だが、AniCastでは目の制御に様々な工夫が凝らしていました。

実際の人間は目を動かすのに筋肉を使うので、目が動けば筋肉が動きます。AniCastではこの現象を再現しており、目のアニメーションは眉や瞼なども連動して動くようになっています。こうする事で目の動きが表情豊かになり、オートで制御しているので技術に属人性が無い事や演者の負担にならない事も魅力です。

XVIさんのUnite「AniCast! 東雲めぐちゃんの魔法ができるまで」講演資料から、目の動かし方の動画です。これは調整前 #unitetokyo2018 pic.twitter.com/pf1rJiOBKK

— PANORA (@panoravr) May 11, 2018

調整前。

XVIさんのUnite「AniCast! 東雲めぐちゃんの魔法ができるまで」講演資料から、目の動かし方の調整後になります #unitetokyo2018 pic.twitter.com/Mcs4NBI44l

— PANORA (@panoravr) May 11, 2018

調整後。

また、セッション内では特に言及していませんでしたが、目にかかるハイライトも振動していました。このハイライトが振動することで、目に潤いを感じさせて、よりキャラクターの生気をより伝えられるわけです。

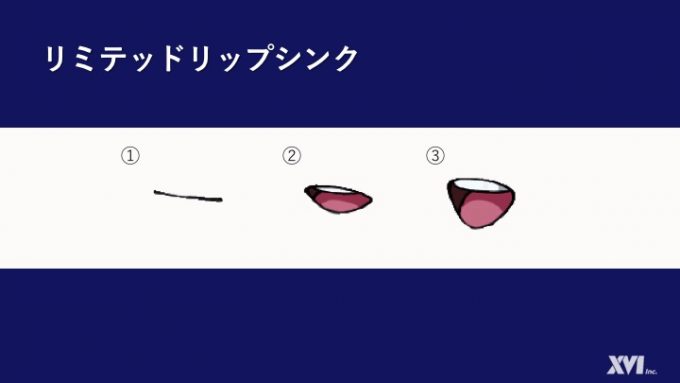

●2.口の表現

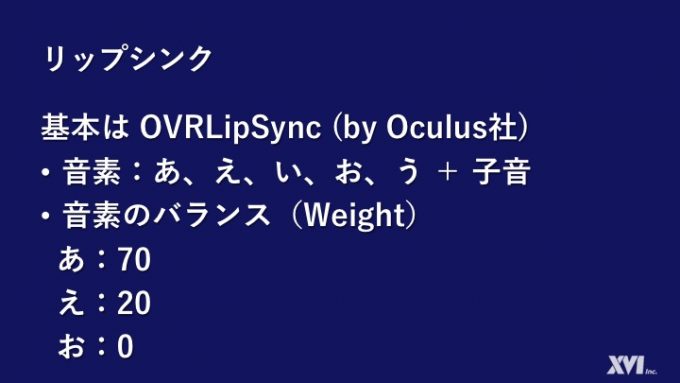

基本は口を動かすプログラムの「OVRLipSync」で制御していますが、そのまま使うのではなくより魅力的になるよう調整していました。

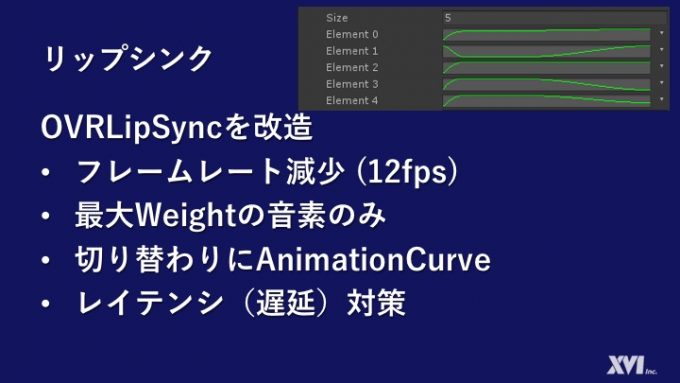

口のブレンドシェイプ(口が変形するアニメーション)はそのままの設定だと等間隔な動きでアニメーションするので、どうしても機械的な動きに見えてしまいます。AniCastでは、アニメーションカーブという設定にすることで、動きに緩急を持たせて印象的に見えるようにしています。

フレームレート(1秒間あたりの絵の枚数)にもこだわっていて、演者の視界となるHMDではVR酔いしないようにハードウェアの90fpsそのままにしている一方で、キャラクターを映しているカメラでは12fpsまで落として、リミテッドアニメーションの表現に近づけていました。

さらに音の遅延対策です。OVRLipSyncでは音の入力を解析してから口の変形に反映させる……という動作の都合上、どうしても発音してから実際にアニメーションするまでにわずかな時間差が存在します。その遅延を極力減らす工夫として、AniCastでは独自プログラム「AniLipSync」で音声入力を取得することで遅延を軽減していました。

このAniLipSyncはGitHubに利用制限が緩めな「MIT License」として公開しており、Qiitaでも解説記事を公開しているので、ぜひとも利用していきたいです。

このプログラムによる遅延低減に加え、動画配信ソフト「OBS」の音声の同期オフセットで250msと設定することにより、自然なリップシンクを実現しています。つまり映像より音を250ms遅らせることで、音と映像のタイミングを合わせているわけです。

ちなみに口の動きの見え方にもこだわっています。

XVIさんのUnite「AniCast! 東雲めぐちゃんの魔法ができるまで」講演資料から、さらに口の動かし方の動画です。これは調整前 #unitetokyo2018 pic.twitter.com/v2jZtf9LQ2

— PANORA (@panoravr) May 11, 2018

調整前。

XVIさんのUnite「AniCast! 東雲めぐちゃんの魔法ができるまで」講演資料から、口の動かし方調整後です #unitetokyo2018 pic.twitter.com/FDZaBih9hh

— PANORA (@panoravr) May 11, 2018

調整後。

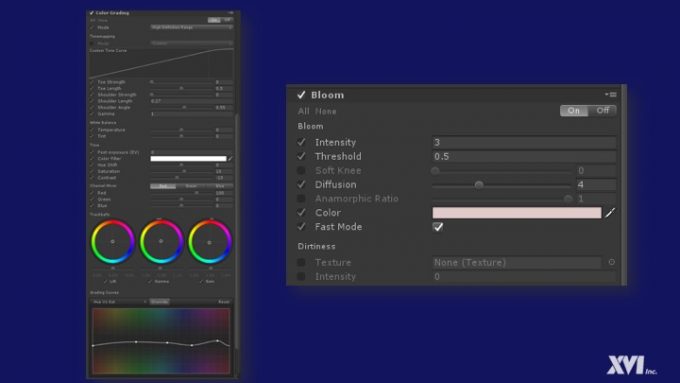

●3.ポストプロセッシングスタックの利用で絵を調整

カラーグレーディング(色調整)することにより主張の強い赤を抑えて、キャラクターを目立たせながら目に優しい画面作りをしています。それに加えて、ソフトレンズなどのフィルターをかけてアニメの質感を出しているそうです。

ビフォアー。

設定。

アフター。

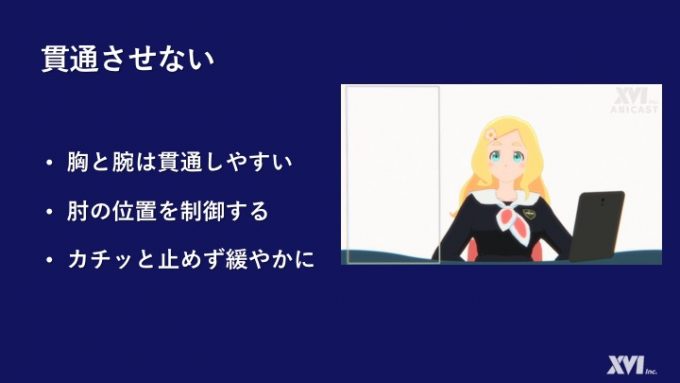

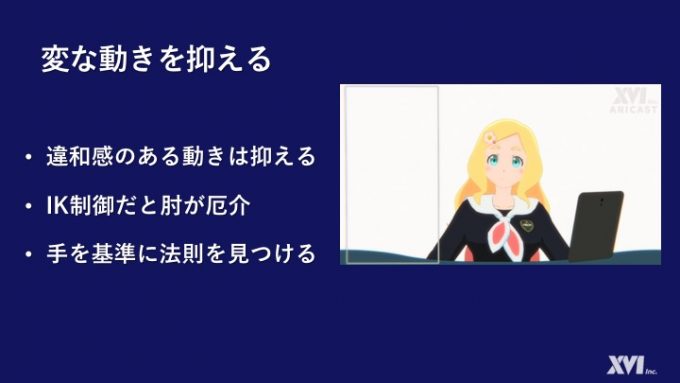

●4.腕のめりこみ対策

特に設定していないIK(キャラクターのアニメーションを作るプログラム)では、肘の位置を厳密に決めることができないので、バーチャルYouTuberでは腕が胸にめり込んでしまいがちという問題があります。

AniCastでは肘の位置を制限することで腕が体にめりこむ現象を防いでいました。これにより、モーションキャプチャーに不慣れな演者でも負担を増やすことなく自然な動きに近づけられます。ちなみに肘を制限する制御は手を基準にして行っているとのことです。

●5.試したが没になったネタ

目線のスティック操作。

AniCastの場合はワンオペを前提に設計しているとのこと。演者が視線を動かすのは熟練が必要で違和感があり、意図しない表情になることがあるのでボツにした。

音声による感情変化。

音量を元に感情を推定しようとしたが、状況により感情が異なるし、声量の数値が安定しないのでプログラムによる判定が難しかった。

●6.音声のデバイス

最初はOculus Rift内蔵のマイクを利用していたとのこと。この内蔵マイクも比較的性能はよく、ノイズキャンセラーなどの性能も悪くないもののより高い音声品質のために、以下のハードに変更したそうです。

・マイク:SHURE ダイナミックマイク ヘッドウォーン「WH20XLR」

・ミキサー:YAMAHA ウェブキャスティングミキサー「AG03」

こちらのミキサーはチャンネル数が少ないものの、配信向けに機能を絞っているため、ワンオペを前提とすると使い勝手がいい定番。チャンネル数が欲しいのであれば1つ上のグレードを検討するのも考えられるでしょう。

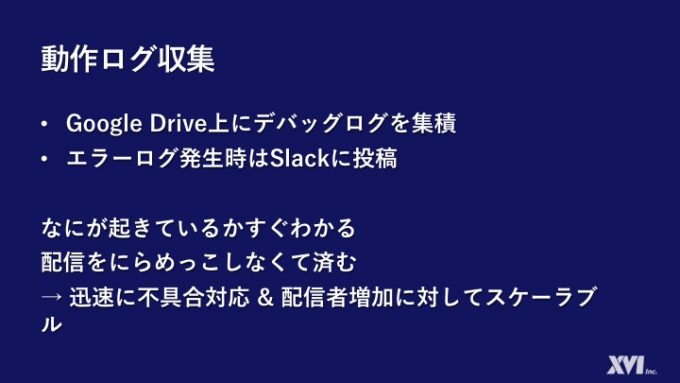

●7.配信の動作ログを収集

演者のCPU、GPU、メモリの使用率、コメントとギフトによる負荷などパフォーマンスを常時集計し、エラーログも収集して、ネットで常時見られるようになっています。何か問題があればSlackに警告が投げられるので、迅速に対応できます。

将来的に演者が増加していった際、1人の演者につき1人のオペレーターをつけるのはスケールしないため、こういった自動のログ収集が負担を下げることに貢献してくれます。エラーログがない場合でも、それは安心感を提供することにつながります。

●まとめ

GOROmanさんが最後に「バーチャルYoutuberはキャラクターの実在感が大きいため、その分喪失した時のショックも大きなものになる。だから、キャラクターを生み出すには責任を持つ必要があるし、AniCastではワンオペを可能とすることでランニングコストを削減し、SHOWROOM様と連携することで運用資金の回収もできるようにしている」と語っていました。

コストについては、ただむやみに安い方がいいので安くするということではなく、キャラクターの寿命を延ばすためのノウハウでもあります。寿命を延ばすことを含めてのキャラクター表現であって、そこからコンテンツ制作に対する愛情も伝わってきました。

講演を通して受けた印象は、目の前の問題を「仕方ない」で済ませるのではなく、解決する前提のマインドが常にあって、そこには思考することをやめないプロフェッショナルを見せつけられて、見習いたいと感じました。

エクシヴィの皆様、実践的かつ非常に有益な知見を公開していただき、ありがとうございました!

©️うたっておんぷっコ♪/(C)Gugenka® from CS-REPORTERS.INC

*Unite Tokyo 2018記事まとめはこちら!

●関連リンク

・東雲めぐ(Twitter)

・東雲めぐ(SHOWROOM)

・エクシヴィ

・Unite Tokyo 2018