小林幸子VRライブを振り返る 360度映像ってどうやって配信してるの?

11月17日、武道館にて行われた演歌歌手・小林幸子さんのコンサートにて、世界初というバーチャルリアリティ生配信が実施されました(ニュース記事)。

ステージそでに置かれた360度カメラで現地を撮影し、インターネットを通じて配信。ユーザーはWindows用アプリを起動してVRヘッドマウントディスプレーの「Oculus Rift」をかぶると、まるで現地にいるように360×180度でライブを体感できるという試みになります。

20日、ドワンゴとNTTは技術発表会を開催して、このライブの技術的な背景を説明したので、その概要をまとめていきましょう。

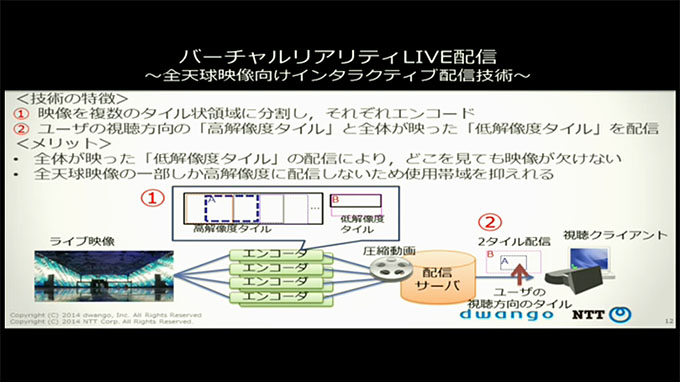

ポイントは、解像度の異なる2つの映像を切り替えることで、ネットワークの帯域を節約しつつ、なるべく高い画質を実現しているということ。頭を回して周囲を眺めているとき低解像度で、一方向を見つめ続けると、その部分だけ解像度を高まるという動作になってます。

もっと詳しい仕組みとしては、まず「Ladybug」という6つのレンズを内蔵した360度カメラで撮影。その映像をまずフルHDにダウンサイズした上で、低解像度/高解像度の2つの映像を生成します。低解像度版は全周で420×240ドット、高解像度版は縦1080ドットで、横は場所によって変えているとのこと。例えば、90度ぐらいの視野角だったら480ドットで、今回は7枚に分割しています。

その2種類の映像をサーバーにおいて、視聴者の挙動に応じて切り替えるという流れです。この解像度を切り替える配信システムを使うことで、普通に全体を送るよりデータ量が3分の1以下におさえられるそうです。

360度カメラのLadybugさん。

側面に5つ、天面に1つレンズがあります。

NTTのメディアインテリジェンス研究所、研究主任の越智大介さんは、「高解像度の全天球の映像をユーザーに届けたのでは、ネットワーク帯域を食ってしまうためまず圧縮する。その際、複数のタイル状に分割して、複数台のエンコーダーで圧縮している。もうひとつ、解像度は高くないけど、なるべく広範囲を撮った低解像度のものも作って2つをサーバーに置き、ユーザーが見てるところは高画質、みてないところは低画質に切り替えている」と説明してました。

気になるのは、どれぐらいの人数に対してライブ配信できるかということですが、ドワンゴのプラットフォーム事業本部 サービス企画開発部 ニコファーレセクション セクションマネージャ、岩城進之介さんによれば「ニコニコ生放送のキャパシティーが使えるので、数万、数十万も可能。大規模配信に向けて設計している」とのこと。

なお、今回の小林幸子さんの視聴者数については「公表してないので、具体的には答えられない。実験的な放送だったので、通常のニコニコ生放送のトップページに出したりという動線を出してなかったので、普通の放送よりは少ない」とのこと。「数百とかですか?」と聞いたところ、「もっと(多い)です」と答えていました。