「いらすとや」でもVTuberできちゃう! アルファコード、静止画を動かすお手軽ツールを参考展示

4月4〜6日に東京ビックサイトにて開催しているコンテンツビジネス展示会「コンテンツ東京」。そこで展開する7つの見本市のうち、「先端デジタルテクノロジー展」にはVR/AR/MRを含む最新技術を使った展示が集まっている(ニュース記事)。

PANORAでも重点的に紹介しているバーチャルYouTuber関連の展示も散見された。またPANORA自体もバーチャルYouTuberをテーマにしたブースを出展しているが、そこに急遽、アルファコードが手がける静止画を使ってバーチャルYouTuberができるツールを参考展示することになった。その詳細をまとめていこう。

バーチャルYouTuberといえば、一般的に3Dモデルを使ったものが目立つが、イラストを元にアニメーションを作成できる「Live2D」などを利用すれば人間のように動かすことも可能だ。iPhone Xを使って上半身のみを動かすいちからの「にじさんじ」でも、「月ノ美兎」ちゃんを始めとする多くのキャラクターが面白いとファンを増やしている。

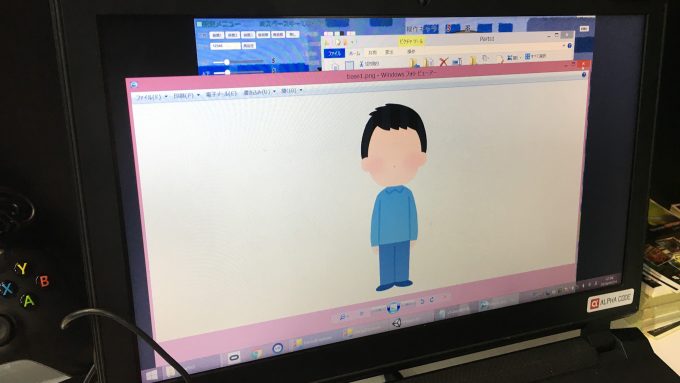

そんな2DイラストでバーチャルYouTuberのハードルをググッと下げてくれそうなのが、アルファコードが開発しているというPC向けの新ツールだ。

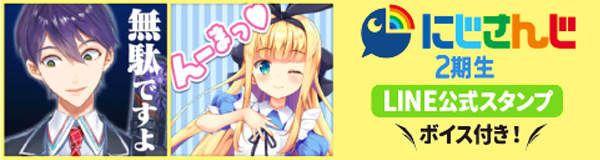

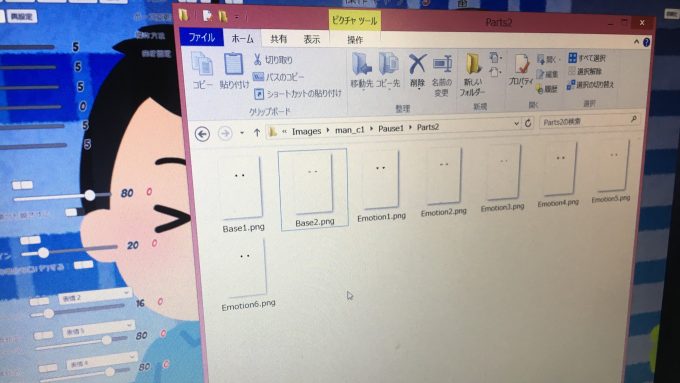

ユニークなのが、表情などの差分を含んだ静止画ファイルを特定のファイル名であるフォルダーに入れると、ウェブカメラやコントローラーを使ってユーザーの表情や体の動きを反映させて動かせるようになるというもの。つまり、PhotoshopやIllustratorなどでレイヤーに分けてつくったイラストを元に、バーチャルYouTuberのようなことができるというわけだ。

土台となる体全体のイラスト。背景も変えられます。

その上に乗せる目、眉、口などの各パーツは、体全体の画像と位置を合わせればいくつかのパターンをつくっておける。これは目の一種。

まぶたを閉じたパターン。

そうして基本の目の表情と、感情のパターンのファイルを用意しておき……。

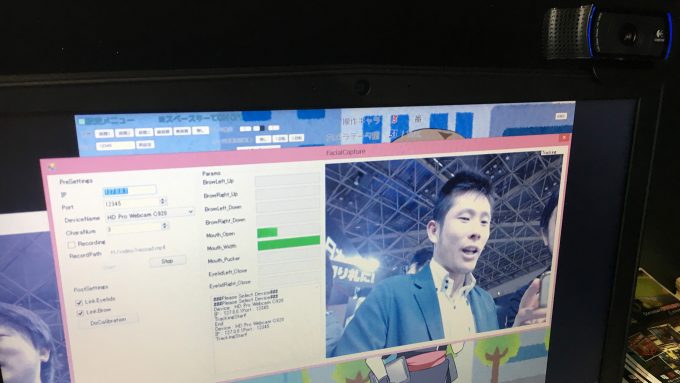

ある程度の表情と体の動きは、ウェブカメラを使って取得する。

さらにコントローラーのボタンを押して特定の表情に変えられる。

ウェブカメラ部分の反応の程度もスライダーで細かく調整可能だ。

さらに体自体の格好も……。

3つのプリセットにチェンジ可能!

— Minoru Hirota@GDC (@kawauso3) April 4, 2018

動画でみるとこんな感じです。

このツールにぴったりなのが、漫画家やイラストレーターだ。絵を描くことについては知識が深いものの、多忙で新しくLive2Dや3Dモデルの制作を学ぶのは難しい。でも自分のキャラクターでバーチャルYouTuberを展開したい……といった際、既存のイラストのスキルだけでキャラを動かせるようになるのが素晴らしい。

もちろん人の動きは3Dモデルに比べて制限は受けるものの、それでもネットラジオのようなキャラクター同士の会話に少し動きをつけたいというニーズにはぴったりだ。なお、現状は1画面最大3人での動作となっているが、仕様的にはもっと人数を追加できるとか。

価格は、主に企業向けに月額数万円で提供することを考えているとのこと。一般向けのニーズが高ければ、Steamでの販売も視野に入れるという。バーチャルYouTuberを安価に実現したいという方は、ぜひ会場を訪れてPANORAブースで確認しておこう。

(TEXT by Minoru Hirota)

●関連リンク

・アルファコード

・先端テジタルテクノロジー展