VRChatなどソーシャルVR用のフルトラッキングセンサーとして、また場所を問わず動きを記録できるモバイルモーションキャプチャーとしてVTuberに人気のデバイス、ソニー「mocopi」。あらたにLive2Dトラッキングアプリ「nizima LIVE」と連携できるようになり、Live2Dモデル(アバター)の手足を自由に動かすためのセンサーとしても使えるようになりました(ニュース記事)。

Live2Dモデルの身体全体を動かせる

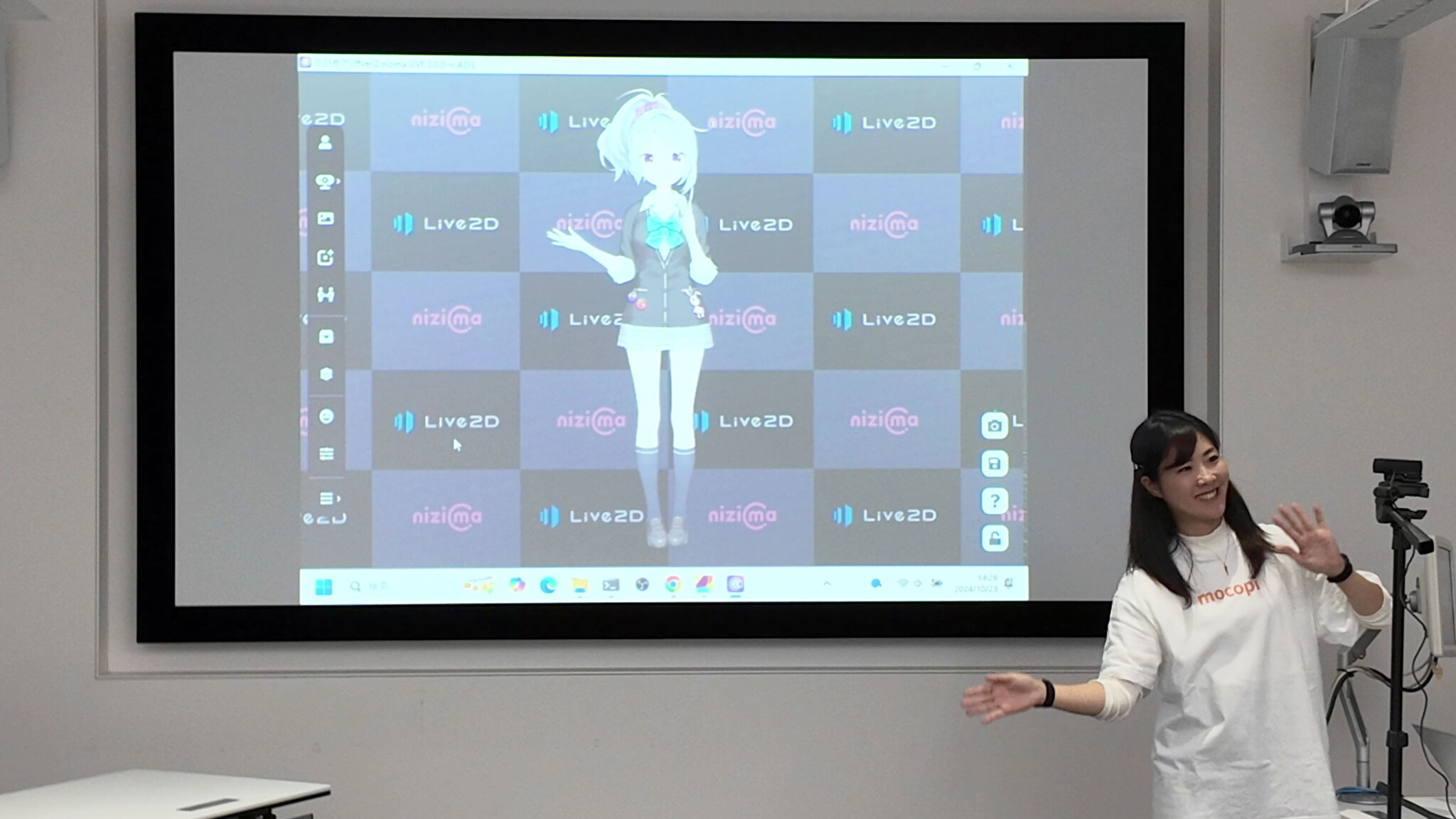

「nizima LIVE」はWindows機/Macの内蔵カメラや、USB接続したウェブカメラ、iPhoneのカメラを用いて、主に顔の表情の動きをトラッキングして、Live2Dモデルを動かすためのアプリでした。

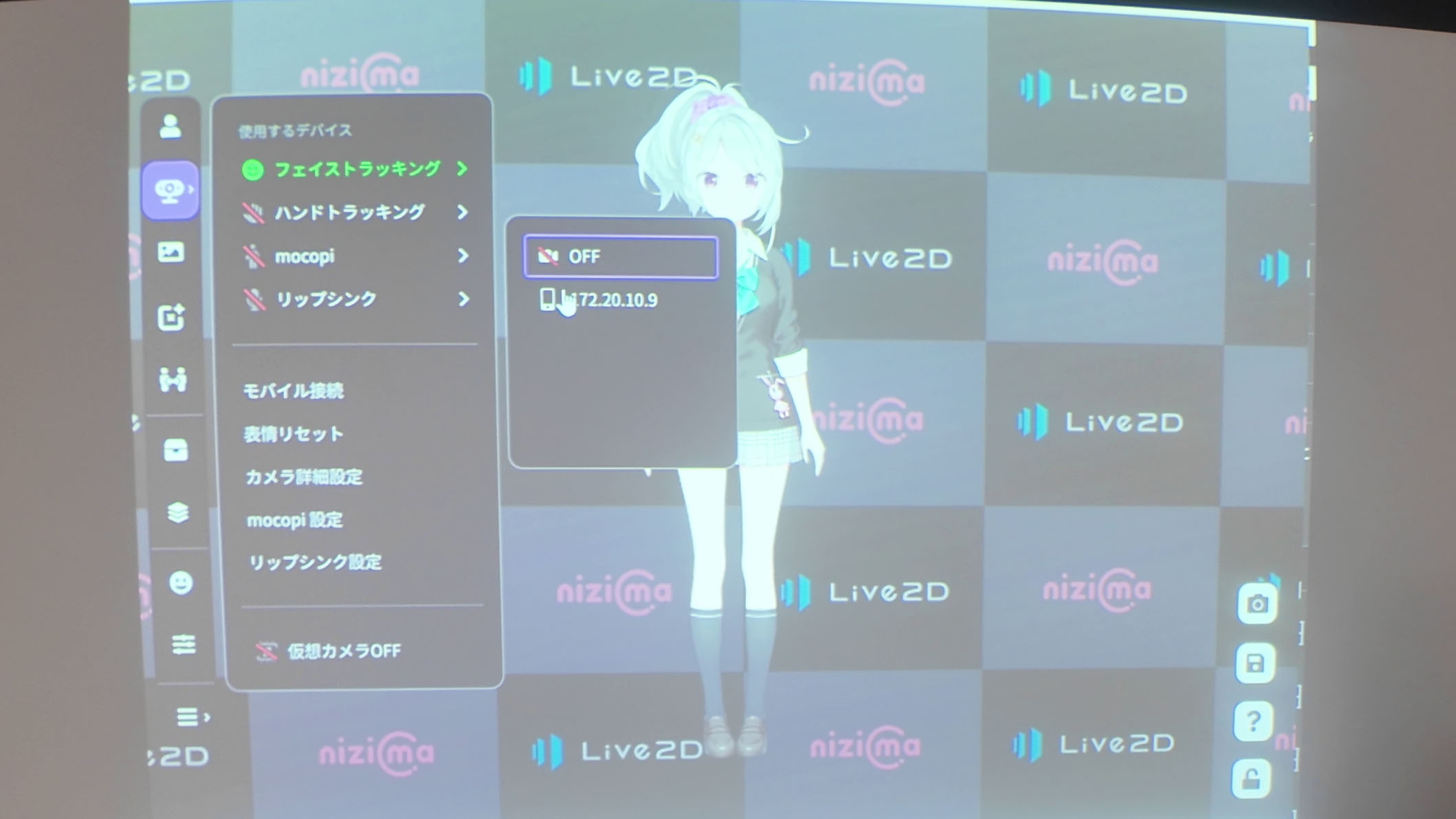

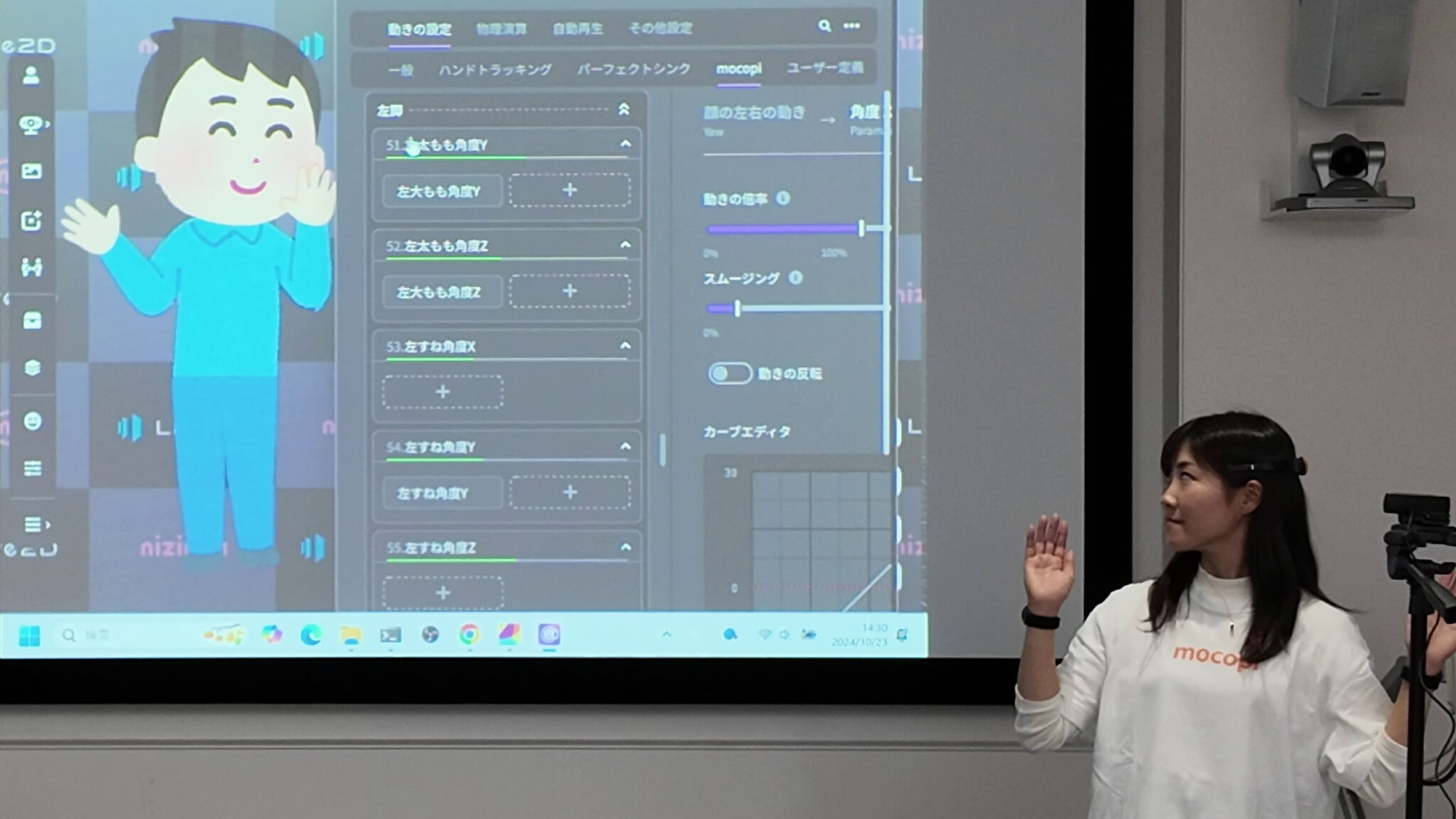

V2.0アップデートでは、前述のようにソニー「mocopi」に対応。下半身のビジュアル、全身のモーションを実装したLive2Dモデルを用意することで、全身・肘・膝・足の位置を測定し、以下の場所の動きが可能となります。

・上半身の動き

・上腕、前腕の角度

・肘の曲げ角

・腰の横振り

・太もも、すねの角度

・膝の曲げ角

また顔の向きと回転角・手の位置・角度など一部のパラメーターも、mocopiから送られてきたデータが使えるようになりました。

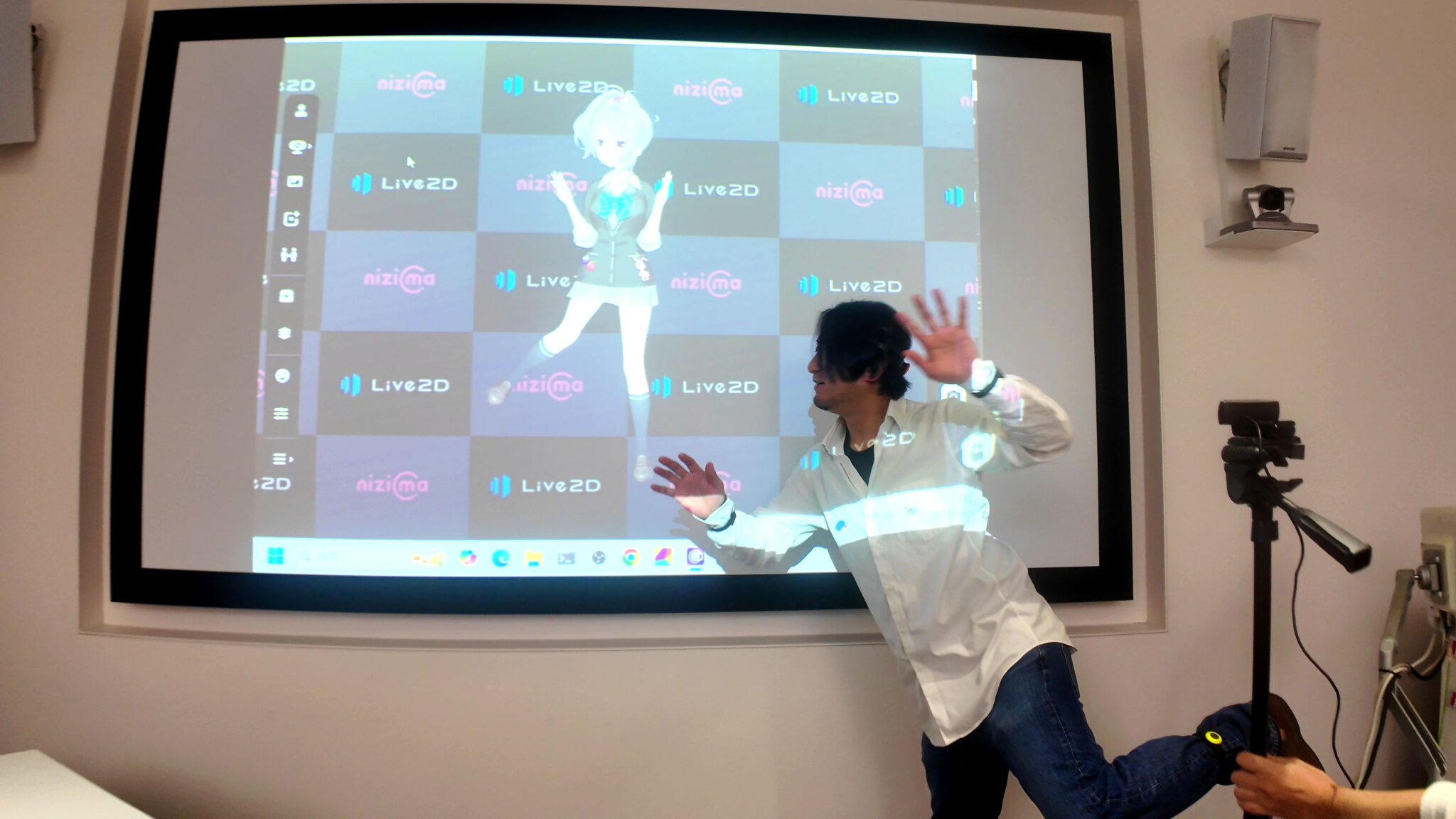

ウェブカメラやスマートフォンカメラを用いたVTuber向けアプリのなかには、カメラの画角に入るのであれば全身のトラッキングに対応したものもあります。しかし、手足を大きく動かしても画角に収める超広角レンズを用いたウェブカメラや、スマートフォンのインカメラ(自撮り用カメラ)は極めて少なく、広角レンズであってもVTuberの中の人から2mは離さないと足の動きまで捉えられないというハードルの高さがありました。

しかし「mocopi」を使うことで、コンパクトなスペースでも全身を使った表現が可能となります。

mocopiアプリから送られてきたモーションデータを「nizima LIVE」が受け取ると、Live2Dモデルの身体を動かせるように変換。動きの倍率などを調整し、思い通りの動きとなるように調整します。

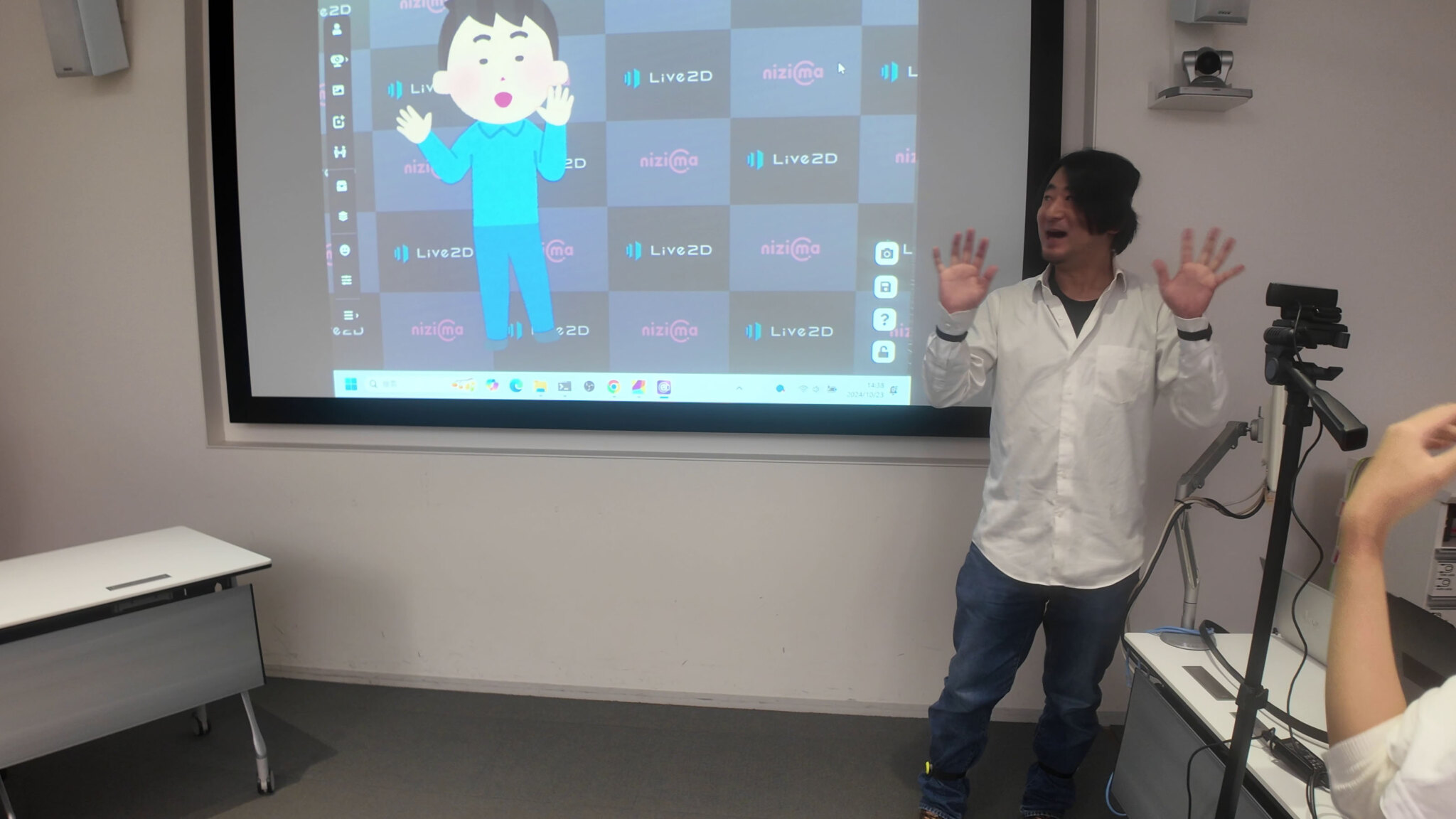

「いらすとや」のLive2Dモデルでフルトラ体験ができる

「mocopi」と「nizima LIVE」ですぐにフルトラッキングを体験できるように、フルトラッキング対応サンプルモデルも配布されます。

その1つが「いらすとや」のLive2Dモデルです。作者であるイラストレーター みふねたかし氏の作風はみなさまご存知でしょう。ミーム動画などでもよく登場しているキャラクターを、顔の表情を含め全身で動かすことができるのはなかなかに面白い体験です。かわいい、かっこいいだけではなく、ほのぼのとしたLive2Dモデルの存在は、いままでVTuber活動に興味を抱けなかった層にもアピールできるでしょうし、裾野の広がりが期待できます。

なお「いらすとや」のLive2Dモデルは順次追加され、近日中に10体が利用可能になるそうです。他にもイラストレーター かにビーム氏描きおろしキャラクター「柊アリサver.2」、全身トラッキング学習用の「mocopi用モデル」なども配布されます。

Live2Dモデル市場の変化にも期待

顔だけ、もしくは顔と上半身のトラッキング向けのLive2Dモデルが多いのが現状ですが、「mocopi」によるお手軽な全身表現が可能になれば、Live2Dモデル市場にも変化が出てくると考えられます。すなわち、手足が動かせるLive2Dモデルの需要増加です。

下半身も含めたモデリングには多くの時間を必要とするでしょう。「いらすとや」のLive2Dモデルのようなシンプルなイラストベースであれば下半身パーツを追加するのに+1~3日、リッチなイラストベースのLive2Dモデルならば+3~10日はかかるそうです。

しかしLive2Dモデルの販売価格の相場アップが期待できますし、新たにLive2Dモデルのモデリングで勝負を仕掛けたい新しいクリエイターにとっても良いチャンスとなるのではないでしょうか。

(TEXT by 武者良太)

●関連記事

・Live2D公式VTuber用アプリ「nizima LIVE」がアップデートで、全身トラッキング対応、いらすとやLive2Dモデル搭載

・ソニーが打ち出す「mocopi」の衝撃 VTuberやVRChatの用途だけでなく、モーキャプのさらなる民主化も

●関連リンク

・nizima LIVE

・nizima

・Live2D

・mocopi